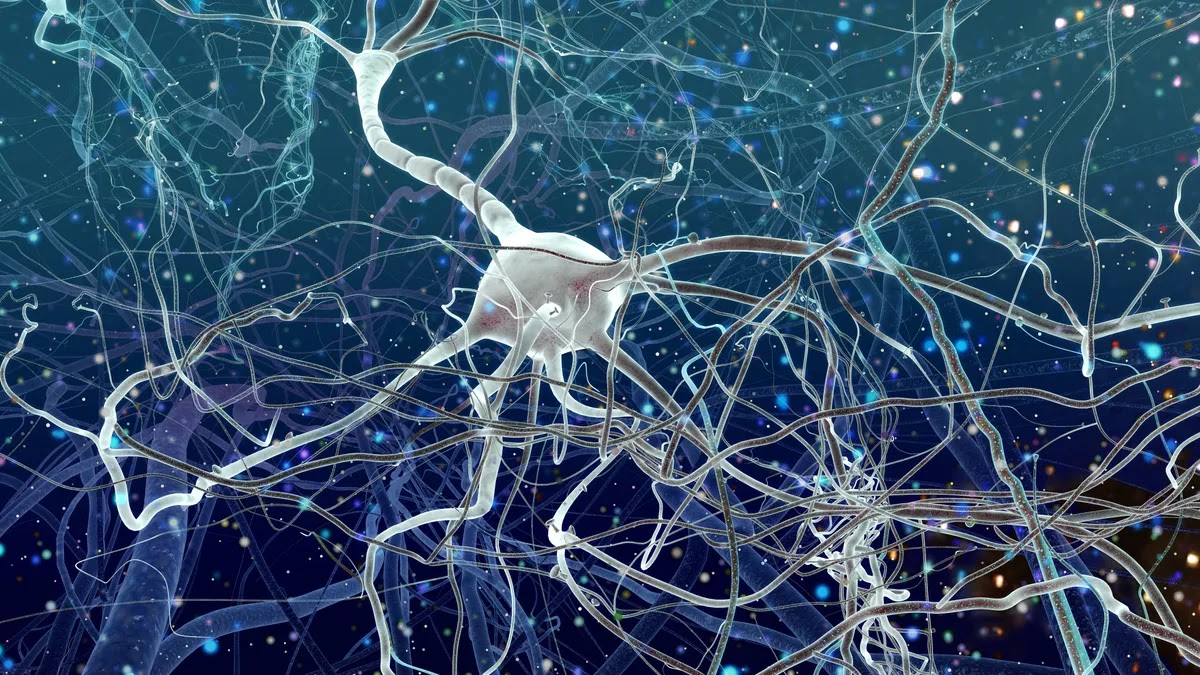

thẻ đồ hoạ Nvidia tiến bộ đã kích hoạt cuộc cách mạng trí tuệ nhân tạo thiết kế theo mạng lưới tế bào thần kinh nhân tạo

Mặc dù thẻ đồ hoạ GPU chạy trơn tru các thuật toán mạng lưới nơ ron, thiết kế chuyên dụng của GPU không phải là để cho mục đích ấy

Các công ty bắt đầu phát triển phần cứng chuyên biệt riêng để chạy những thuật toán AI – lấy tên là những bộ tăng tốc AI

hôm nay, thị trường phần cứng ‘bộ tăng tốc AI’ ước tính trị giá hơn 35 tỷ đôla

năm 2021 các nhà đầu tư mạo hiểm rót hơn 2 tỷ đôla cho các công ty khởi nghiệp thiết kế vi mạch AI

TSMC coi phần cứng tăng tốc trí thông minh nhân tạo [AI] là một trong những động lực tin cậy hàng đầu kiếm doanh thu trong tương lai gần

Khởi đầu

Năm 2011 một đội của hai trường đại học New York và Yale xuất bản một bài viết trong hội thảo CVPR [computer vision and pattern recognition] – bài viết đề xuất một kiến trúc phần cứng có thể mở rộng giành cho những mạng lưới tế bào thần kinh nhân tạo [thuật toán AI] học sâu

Lúc ấy, cộng đồng nghiên cứu AI phần lớn đã chấp nhận GPU làm phần cứng tiêu chuẩn khả dụng để chạy và thẩm nghiệm các thuật toán, nhưng bài viết chỉ ra rằng phần cứng chuyên biệt có thể cải thiện hiệu năng và tiêu thụ điện gấp 100 lần

Từ lâu, các mô hình học sâu đã xử lý hình ảnh với những bước đường ống tuần tự [sequential pipeline] trong mạng lưới thần kinh, ví dụ vi xử lý trong điện thoại biến dữ liệu hình ảnh thô thu được từ cảm biến thành một bức ảnh hoàn chỉnh hiện lên màn hình

Bài viết năm 2011 đề xuất một kiến trúc xử lý song song mỗi bước một và triển khai lên một thuật toán thị giác máy tính.

Họ thi hành một kiến trúc lưới dữ liệu trên một chip FPGA chiếc Xilinx Virtex 6 là một vi mạch cho phép tuỳ chỉnh cấu hình, và đã thu được cải thiện đáng kể

Đáng lưu ý là những chip FPGA là công cụ phát triển và thẩm nghiệm, nên tốc độ thường chậm, nên đội cũng đã ra mắt trên lý thuyết một thiết kế vi mạch 45 nanomet được fab [khắc đúc] bằng tiến trình của IBM, vi mạch mới cho các đối thủ ngửi khói

Hàm số và kết luận

những mạng lưới thần kinh [nhân tạo] căn bản là một hàm số toán học khổng lồ, sử dụng những bước xử lý đơn giản để mô hình hoá những mối quan hệ phức tạp giữa nhiều dữ liệu nạp vào

một mạng lưới thần kinh AI được trình bày dưới dạng các ma trận, đầu tiên biến hình ảnh đầu vào thành một ma trận dữ liệu làm đại diện, sau đó gửi dữ liệu đầu vào qua nhiều lớp của mạng thần kinh, thực hiện bằng cách nhân ma trận đầu vào với các ma trận cân trọng lượng, rồi dùng một hàm toán đặc biệt – tên là một hàm số kích hoạt – cho ra kết quả

hai vai trò của bộ tăng tốc xử lý AI: đầu tiên là ở công đoạn huấn luyện mà ta sử dụng những bộ dữ liệu lớn để tính những giá trị cân trọng lượng dùng cho nhiều lớp của mạng lưới

thứ hai là công đoạn kết luận: hàm số mạng thần kinh đã qua huấn luyện sẽ được sử dụng để kết luận ra kết quả từ dữ liệu đầu vào, là khi biến hình ảnh thành một ma trận dữ liệu và bắt đầu nhân với các ma trận cân trọng lượng và áp dụng các hàm số kích hoạt

ấy là khi ta cho mạng lưới xem ảnh một con chó và nó trả lời là có một con chó trong bức ảnh [hi vọng]

những bộ tăng tốc mạng thần kinh [AI] hoạt động hiệu quả hơn những người đồng nghiệp thông dụng là CPU và GPU vì được tuỳ chỉnh để xử lý phép nhân ma trận và những bước tích chập – chiếm đến 90% công việc

Google năm 2016 đã khảo sát số phép tính cho mạng thần kinh, cho thấy một số mạng lưới có đến 100 triệu phép nhân ma trận trọng lượng

Hiện thực hoá

Khái niệm dần được hiện thực hoá và một cộng đồng nhỏ các dự án phần cứng AI đã nở rộ

Ví dụ năm 2015 dự án ShiDianNao của khoa hàn lâm khoa học Trung Quốc thuộc học viện công nghệ tính toán làm ra một bộ phần cứng tuỳ chỉnh để chạy một loại mạng lưới thần kinh nhất định – thích hợp cho những ứng dụng thị giác máy tính

Bộ tăng tốc 65 nanomet ShiDianNao tiêu thụ ít điện hơn một thẻ đồ hoạ và đủ nhỏ để tích hợp vào bất cứ cảm biến hình ảnh thương mại nào nằm trong một sản phẩm

CAS (khoa hàn lâm khoa học Trung Quốc) đã mở rộng phần cứng thành 4 loạt sản phẩm là cơ bản, tuỳ chỉnh, huấn luyện/học và cho những mục đích thị giác máy tính

Dự án đáng chú ý khác là Eyeriss bộ tăng tốc thích nghi cho các thiết bị di động chạy các mạng thần kinh, dự án của MIT một phần được DARPA tài trợ

Vi mạch Eyeriss để chạy kết luận cho những hình ảnh, sử dụng một mô hình đã huấn luyện sẵn, chưa kể hiệu quả tiêu thụ điện tiết kiệm gấp 10 lần GPU bấy giờ

Dự án nữa là TeraDeep của các thành viên đội xuất bản bài viết năm 2011 trong hội thảo CVPR – dự án ra mắt vi xử lý nn-X trang bị khả năng học sâu cho những webcam và phần cứng cũ

Khách [edge] và máy chủ [server]

Ba dự án có một điểm chung: sản phẩm vi xử lý thường tập trung vào tính kết luận ra kết quả bằng cách dùng những mô hình đã được huấn luyện sẵn – phần cứng chuyên biệt cho kết luận – nhưng khác nhau ở nơi thực hiện việc ấy và nhờ đó ta phân loại được chip

Nên, bên cạnh chia ngành ra 2 hướng tập trung vào huấn luyện hoặc kết luận, ngành phần cứng AI còn phân loại thêm ra phụ thuộc vào môi trường mà chúng [vi mạch] vận hành: Edge hoặc Server

Chip AI “Edge” được đặt trực tiếp vào thiết bị như điện thoại thông minh, ôtô, thiết bị internet vạn vật hoặc công nghệ mang trên người và do đó, nhà thiết kế phải tính đến những hạn chế điện năng và kích cỡ của dạng thức này

Chip AI máy chủ thì các công ty phần lớn lo ngại về tỷ lệ chi phí/hiệu năng mà điện tiêu thụ chiếm tỷ trọng đáng kể tổng chi phí sở hữu chip, nên các trung tâm dữ liệu muốn hiệu năng cao nhất có thể ở mức giá thành nhất định

Vì thế những chip máy chủ này thuộc phân khúc cao cấp gần thời thượng nhất, phát triển những thiết kế như vậy tốn nhiều tiền và nguồn lực làm tăng vốn đầu tư trả trước

Căn bản, tất cả các bộ tăng tốc AI được xếp vào sử dụng hai trục: để huấn luyện hoặc kết luật, để máy chủ hoặc khách [Edge]

Bấy giờ, những bộ tăng tốc AI phần lớn vẫn là dự án nghiên cứu chiết xuất ra từ những công ty khởi nghiệp nhỏ hoặc từ trường đại học. Thị trường không lớn mạnh trước khi Google tuyên bố năm 2016

Google và đơn vị xử lý tensor [TPU - tensor processing unit]

Google đã nghĩ đến việc làm vi mạch riêng từ năm 2006 nhưng năm 2013 mới mó tay khi công ty thấy được nhu cầu tính toán khổng lồ cho huấn luyện và triển khai những mạng thần kinh nhân tạo cần cho máy chủ công ty

TPU đơn vị xử lý tensor được thiết kế và gia công [fab] trên tiến trình 28 nanomet, chiếc đầu tiên được lắp vào các trung tâm dữ liệu Google năm 2015 và công bố báo chí tháng 5 năm 2016

Vi mạch giống TPU được gọi tên là ASIC vi mạch tích hợp chuyên dụng, trường hợp của TPU thì ứng dụng là nhân ma trận

Trái tim của TPU là một “đơn vị nhân ma trận” chứa 65536 mạch bộ tích luỹ nhân – còn gọi là những đơn vị MAC – xếp trên một mảng 256*256

Mạch bộ tích luỹ nhân được thiết kế để làm một việc duy nhất là nhân hai số và tích luỹ kết quả vào một số tổng

khi TPU được sử dụng, đơn vị nhân ma trận nhận và xử lý 2 thứ: đầu tiên là dữ liệu ảnh từ CPU chủ [bộ nhớ chính] của TPU – dữ liệu ảnh mà ta muốn có kết luận – thứ hai là của mạng thần kinh nhân tạo, hàng triệu phép nhân ma trận trọng lượng được tải về từ bộ nhớ DRAM DDR3 vào đơn vị nhân ma trận

so với những chip máy chủ bấy giờ như CPU thế hệ Haswell 18 lõi của Intel và GPU Nvidia Kepler K80 thì chiếc TPU có nhiều đơn vị bộ tích luỹ kết quả nhân hơn và cũng có bộ-nhớ-lưu-trữ-kết-quả-trung-gian trên chip cao hơn

đương nhiên CPU và GPU được thiết kế cho việc khác mà TPU không làm được như hiện hình trò chơi hay chỉnh sửa ảnh

mục tiêu thiết kế TPU là để đảm bảo rằng đơn vị nhân ma trận liên tục được sử dụng. Những thế hệ TPU mới đây đã có thể chạy hàng nghìn tỷ phép toán dấu chấm động mỗi giây

Lợi ích của TPU

TPU không quá phức tạp, chỉ là một máy đại số tuyến tính khổng lồ, nhưng được làm rất chuyên biệt nên nhờ đó thế hệ TPU đầu tiên của Google có thể chạy kết luận nhanh gấp 15-30 lần và tiết kiện điện năng 30-80 lần hơn lựa chọn khác bấy giờ

Google thay TPU vào các trung tâm dữ liệu, giúp công ty không cần mua CPU lẫn GPU và tiết kiệm hàng triệu đôla tiền máy chủ

Google cũng có khung phần mềm học máy riêng TensorFlow cho phép tuỳ chỉnh chính xác phần cứng cho cái phần mềm làm

với cả phần cứng và mềm, Google phát triển một hệ thống học máy quy trình đầu cuối để làm những cái như tìm vật trong 8-10 năm lượng dữ liệu tải lên Google Photos

Google không làm sản phẩm TPU để bán – công ty coi ấy là lợi thế cạnh tranh – nhưng khách hàng có thể thuê quyền sử dụng thông qua dịch vụ điện toán đám mây Google

Cạnh tranh máy chủ

Google căn bản đã tạo nên ngành công nghiệp ASIC [vi mạch tích hợp chuyên dụng] AI máy chủ nhưng các công ty khác cũng đuổi theo

Amazon có AWS là trung tâm dữ liệu đám mây lớn nhất – đã khẳng định được ưu việt của thiết kế chip riêng Graviton là một CPU dựa kiến trúc ARM đã bắt đầu trở thành lựa chọn thay thế cho CPU máy chủ của Intel

Tháng 12 năm 2020 Amazon tuyên bố những thiết bị Trainium là bộ tăng tốc huấn luyện AI riêng

Những lựa chọn mới này là thử thách cho công ty làm GPU và những phần cứng khác cho máy chủ AWS ví dụ như Habana – công ty Habana thành lập năm 2016 bán sản phẩm cho trung tâm dữ liệu huấn luyện các mô hình học máy, công ty được Intel chi 2 tỷ đôla mua lại tháng 12 năm 2019, quyết định đúng đắn trước khi Amazon ra mắt Trainium

Nvidia cũng có phần cứng AI tự thiết kế: chiếc Tesla V100 không phải GPU mà là một bộ xử lý AI có hơn 20 triệu bóng bán dẫn và 5120 lõi – cùng lợi thế cạnh tranh về phần mềm thì công ty là một đối thủ đáng gờm

Với những công ty khởi nghiệp nhắm vào thị trường máy chủ AI, cuộc cạnh tranh khốc liệt giữa các công ty khởi nghiệp trị giá tỷ đôla và những tập đoàn công nghệ khổng lồ hàng tỷ đôla, đã khiến việc định vị phương hướng có phần khó nhằn

Một khi những khách hàng lớn nhất bắt đầu làm chip AI riêng và định vị những chương trình riêng theo ấy thì không còn dễ nữa

Các đơn vị xử lý thần kinh nhân tạo

Thị trường máy chủ trở nên cạnh tranh hơn với người ngoài cuộc, thì phía bên kia [khách] tình hình cũng không khả quan

Thông tin tài chính lưu ý rằng một nửa thị trường chip AI là cho chip AI chuyên biệt cho điện thoại di động – có thể là xử lý ảnh

Nhưng các nhà làm vi xử lý di động cũng đang cố lấn vào cơ hội mới ấy, bằng cách tăng trưởng và mở rộng phần cứng mạng lưới thần kinh tích hợp trong chip

Năm 2017 Apple tiên phong chip A11 Bionic trong iphone X có phần cứng mạng lưới thần kinh chuyên biệt khắc vào nó [vi mạch bán dẫn] – nhân xử lý trí tuệ nhân tạo Neural Engine, thế hệ đầu tiên có 2 lõi có khả năng làm 600 tỷ phép tính mỗi giây

Apple kiểm soát toàn bộ bộ sưu tập phần mềm [của phần cứng iphone], cho nên việc tích hợp này khá chỉn chu

Neural Engine đầu tiên chỉ dùng cho nhận diện khuôn mặt và Animoji của iphone X nhưng năm sau ấy công ty ra mắt thế hệ 2 cho người dùng tiếp cận giao diện lập trình ứng dụng CoreML [khung phần mềm cho học máy]

Những nhà bán chip các cũng đang bổ sung chức năng AI chuyên dụng – ví dụ công ty thiết kế chip MediaTek và loạt vi xử lý di động Dimensity 5G

Nhiều cơ hội cho bước “kết luận” (inference) trên thiết bị “khách” (Edge) – internet vạn vật, xe tự hành... – nhưng không nhiều thiết bị di động có lãi cao như điện thoại và nỗ lực kỹ thuật hỗ trợ những sản phẩm điện năng thấp và tức thời [low-latency] thì khó hơn

Quang tử silic và AI

Kể cả những kiến trúc chuyên biệt này thì những bộ tăng tốc AI có thể mất hàng giờ hoặc lâu hơn để huấn luyện một mô hình học máy cho lĩnh vực sản xuất

Một đề xuất là triển khai những chip AI mới sử dụng quang tử silic

Máy chủ trong các trung tâm dữ liệu ngày nay hoạt động giống như bất cứ máy tính nào khác, có CPU và ngân hàng bộ nhớ tách biệt trong thiết kế được gọi tên là kiến trúc Von Neumann kể từ thập niên 1940

Các mạng lưới thần kinh nhân tạo đặt ra thử thách với kiến trúc này, bên cạnh việc mạng lưới phần lớn là song song, tách biệt giữa vi xử lý [CPU] và bộ nhớ làm chậm đáng kể tốc độ - giống như não bộ lưu trữ các Synapse và các nơ ron ở hai vị trí tách biệt

Các sản phẩm quang tử silic sử dụng ánh sáng thay vì điện để gửi tín hiệu - ánh sáng có thể du hành qua cáp quang mà không lo quá nhiệt

Kết

Ý tưởng so sánh ngành phần cứng bộ tăng tốc AI và ngành phần cứng đào Bitcoin là khá cám dỗ - hai ngành đã chung một con đường: với CPU rồi GPU và rồi đến thời đại của các ASIC

Với các thợ đào Bitcoin thì bước mới có vẻ luôn tìm đến tiến trình tiên tiến hơn, nhưng chưa chắc bộ tăng tốc AI phải đi theo hướng ấy, hướng đi mà những công ty chip lớn như Nvidia sẽ dễ dàng và nhiều nguồn lực để tiếp cận hơn

Hướng đi thú vị hơn cho bộ tăng tốc AI là từ những công ty tìm ra cách mới để đạt được kết quả ngang hàng trong việc kết luận hoặc huấn luyện mà không cần tiến trình gia công mới – có thể là quang tử silic hoặc cấu trúc song song tiên tiến mới

Không có nhận xét nào:

Đăng nhận xét